What’s wrong with spreadsheets?

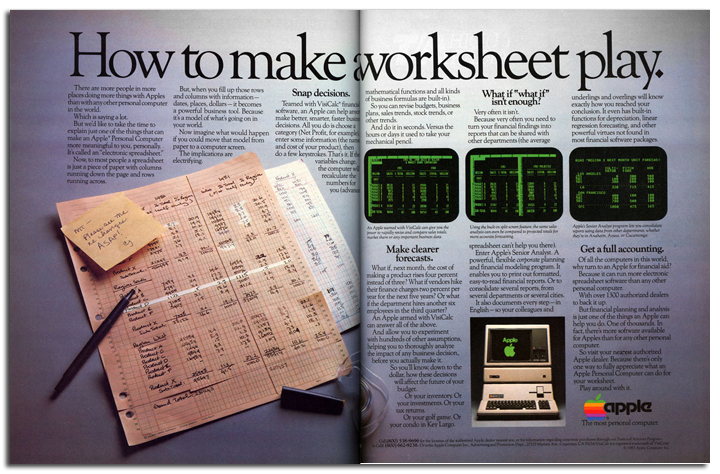

Tabellenkalkulationsprogramme waren eine Revolution. Damit wurden Anfang der 1980er Jahre der Computer von einem „Spielzeug“ für Wissenschaftler und Freaks zu einem Hilfsmittel für alle, die etwas zu berechnen hatten. Und so wurden Tabellenkalkulationsprogramme bis heute milliardenfach verkauft. Ob es ein geeignetes Werkzeug für das Financial Modeling ist, bleibt fraglich, denn empirische Studien haben gezeigt, dass mehr als die Hälfte aller Tabellenkalkulationen falsch sind. Über 35 Jahre nach der Erfindung von VisiCalc ist es deswegen höchste Zeit für ein besseres Werkzeug.

Warum sind Tabellenkalkulationsprogramme für Financial Modeling so schlecht geeignet? Weil wir Menschen und keine Maschinen sind! Die Darstellungsform in Zellen ist zu abstrakt und Zellbezeichnungen in Formeln sind nicht intuitiv verständlich. Sprechende Formeln, Diagramme, Hierarchien, Wahrscheinlichkeitsverteilungen usw. helfen uns, komplexe Dinge zu verstehen.

Ein Modellierungswerkzeug wie Analytica, das diese Dinge graphisch darstellt und den Benutzer direkt mit ihnen arbeiten lässt, ist viel intuitiver zu benutzen. Der Mensch muss nicht mehr ständig zwischen seinem eigenen „inneren Modell“ und dem, was die Software darstellen kann, übersetzen. Analytica macht es daher viel einfacher, Modelle zu erstellen, zu erklären, zu überprüfen und zu erweitern. Fehler im Modell reduzieren sich dadurch erheblich, weil Analytica viele Fehlerquellen bereits von vornherein konzeptionsbedingt ausschließt. Und wenn sich doch Fehler einschleichen, was immer passiert, wo Menschen arbeiten, dann sind diese in Analytica viel leichter zu finden und zu beheben.

Hier sind die 10 größten Probleme von Excel — und wie Analytica sie überwindet.

Kryptische Zellbezeichnungen erschweren das Verständnis.

Excel-Formeln beziehen sich auf Variablen, die durch kryptische Zelladressen, wie z.B. B2 für Spalte B und Zeile 2, gekennzeichnet sind. Jeder Excel-Anwender weiß, wie schwierig es sein kann, eine Excel-Formel zu verstehen und zu überprüfen, die man selbst oder jemand anderes geschrieben hat.

Analytica verwendet sprechende Bezeichnungen für jede Variable.

Formeln sind viel leichter zu schreiben, zu verstehen und zu korrigieren.

Es gibt keine strukturierte und konsistente Dokumentation.

Ein Excel-Modell wird häufig so dokumentiert, dass Texte entweder in Kommentaren oder direkt in Zellen erfasst werden, die keine Zahlen oder Formeln enthalten. Es ist zwar üblich, Namen, Einheiten oder Beschreibungen direkt in eine Zelle neben der zu beschreibenden Zelle zu platzieren, aber feste Regeln dafür gibt es nicht. Denn man muss diese Dokumentation immer „händisch mitziehen", wenn sich die Position der Variablen oder ein Formeln ändert, weil kein konsistenter Zusammenhang zwischen Objekt und Beschreibung besteht. Das ist aufwändig, fehleranfällig und meist wird es sogar vergessen.

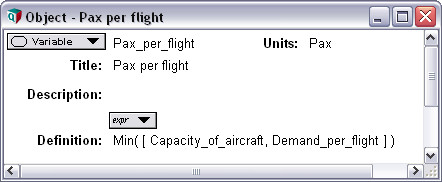

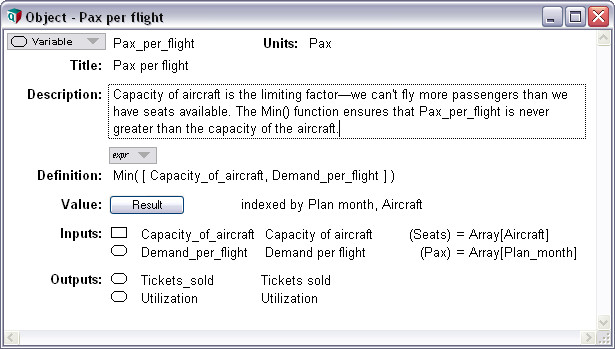

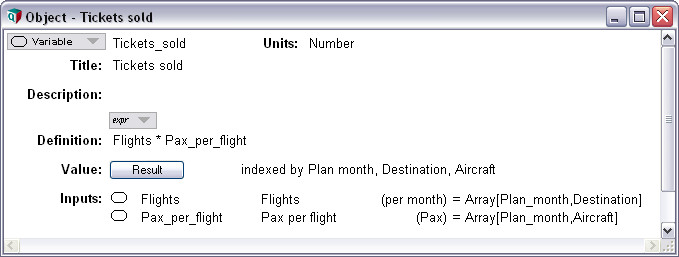

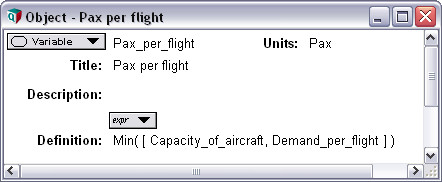

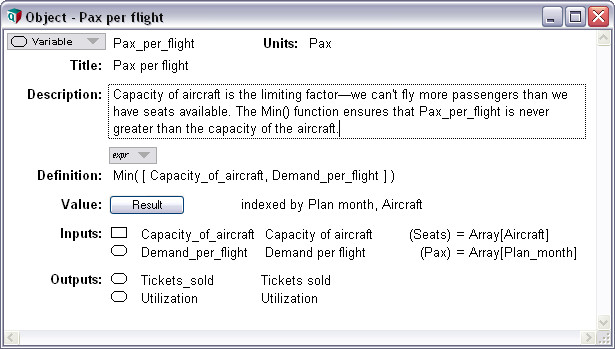

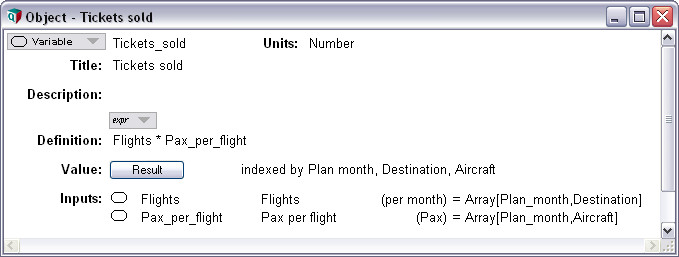

Dokumentation ganz leicht: In Analytica hat jedes Objekt einen „Steckbrief“.

Jedes Objekt im Modell enthält immer standardisierte Felder, wie Bezeichnung, Einheit, Beschreibung und natürlich die Berechnungsformel. Die Dokumentation kann — und sollte! — praktisch parallel zur Erstellung des Modells erfolgen.

Bedeutung unklar — Zellen haben keine definierten Rollen.

Eine Excel-Zelle kann Zahlen, Formeln, Textwerte oder Dokumentation enthalten — oder sie ist einfach leer. Wenn eine Zahl angezeigt wird, kann das eine Eingangsgröße, ein End- oder Zwischenergebnis sein. Das Problem dabei ist, dass eine Zelle immer nur eine eine Zelle ist und man nicht erkennen kann, welche Rolle sie im Modell spielt. Für den Betrachter eines Excel-Modells ist es schwer, Textwerte von Dokumentation, Inputs von Outputs oder Entscheidungs- von Zielgrößen zu unterscheiden. Und weil man diese unterschiedlichen „Rollen“ einer Zelle nicht explizit festlegen kann, kann Excel natürlich auch nicht prüfen, ob das Modell formale oder logische Fehler enthält.

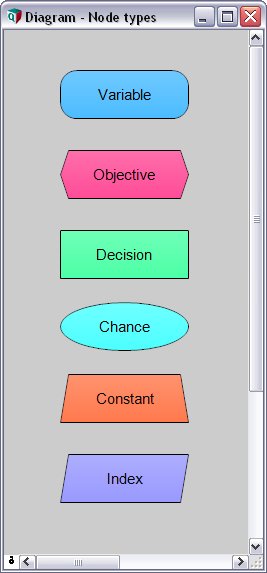

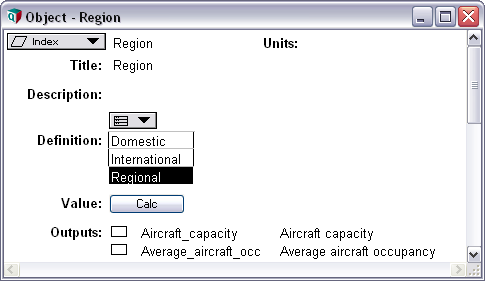

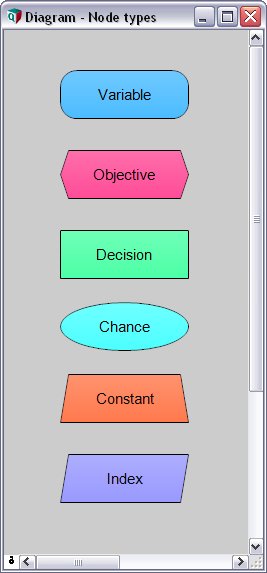

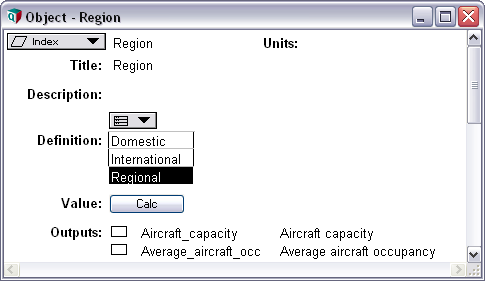

An jedem Objekt ist klar erkennbar, welche Rolle es im Modell spielt.

Jedem Objekt wird durch die Software automatisch eine Rolle, wie Input, Konstante, Verteilung, Ergebnis oder Index zugeordnet. Damit werden konzeptionelle Fehler vermieden und der Anwender versteht die Bedeutung der Objekte auf einen Blick.

Die Modellstruktur ist bleibt im Verborgenen.

Excel bietet keine Möglichkeit, die gesamte Struktur eines Rechenmodells auf einen Blick zu visualisieren. Durch die kryptischen Zellbezüge in Formeln kann es sehr mühsam sein herauszufinden, welche Variablen bzw. Zellen voneinander abhängen. Natürlich bietet Excel zwar Möglichkeiten wie die farbliche Markierung von Zellen oder die Detektivfunktion, mit der Vorgänger und Nachfolger aufgespürt werden können. Wirklich hilfreich ist das nicht, weil man sich durch jede Zelle klicken muss und bei komplexen Modellen die Abhängigkeiten zu umfangreich sind, um die Darstellung zu verstehen. Excel ist lediglich ein Rechentool und kein Visualisierungswerkzeug.

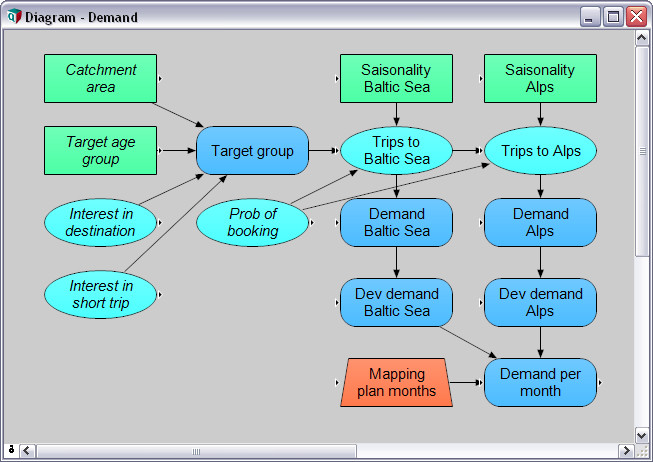

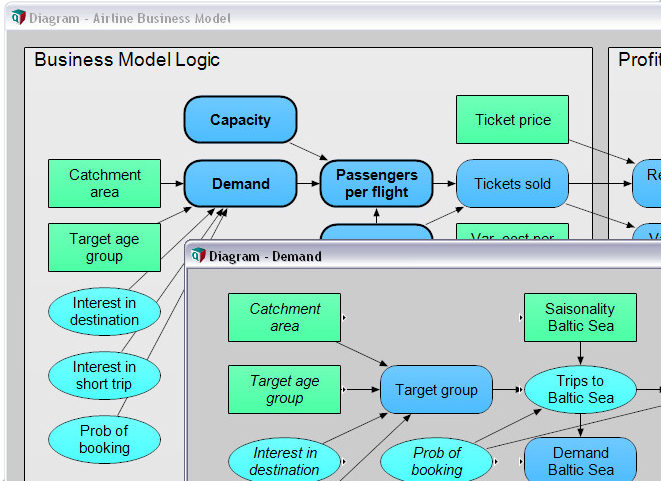

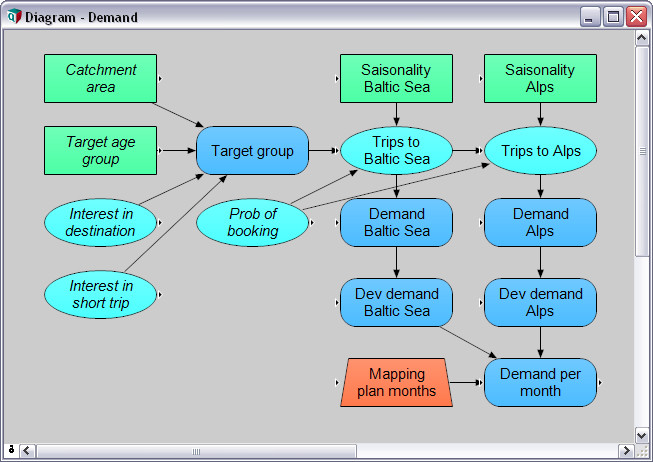

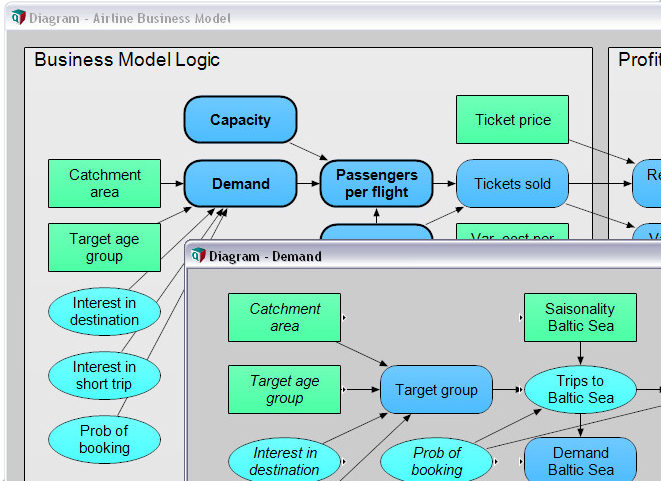

Durch Einflussdiagramme wird das Modell visualisiert.

Die Einflussdiagramme zeigen sowohl die beteiligten Objekte als auch die gegenseitigen Abhängigkeiten. Das hilft dem Modellentwickler wie auch den Entscheidern und anderen Interessierten, die Zusammenhänge und Annahmen im Modell zu diskutieren. Das Modell wird damit zum Kommunikationstool. Außerdem ist es damit sehr leicht, auch innerhalb umfangreichster Modelle zu navigieren.

Modularer Aufbau wir nur unzureichend unterstützt.

Um komplexe Modelle einfach handhabbar zu machen, ist es sehr hilfreich, wenn man sie modular aufbaut sind. Dabei sollte jedes Modul nur so groß sein, dass man es noch überblicken und verstehen kann. Excel unterstützt diesen Gedanken lediglich durch die Möglichkeit, in einer Datei mehrere Arbeitsblätter anzulegen. Diese Art von Modularität wird allerdings bereits dann gestört, wenn man weitere Arbeitsblätter für zusätzliche Dimensionen (z.B. Produkte, Regionen, Geschäftsbereiche) anlegen muss. Das passt dann inhaltlich nicht mehr zusammen. Erfahrene Excel-Anwender organisieren komplexe Modelle innerhalb der Arbeitsblätter durchaus modular. Aber Excel selbst weiß von dieser Struktur natürlich nichts und bietet keine Unterstützung zur Organisation komplexer Modellhierarchien.

Vom großen Ganzen zum Detail — Teilmodelle werden in Module „verpackt“.

Durch die Möglichkeit, Teilmodelle in Module zu „verpacken“, werden komplexe Modelle handhabbar. In jedem Modul ist nur das enthalten, was dafür wichtig ist. Weniger relevante Details können so bspw. in Sub-Modulen „versteckt“ werden.

Formeln beziehen sich auf Zellen und nicht auf ganze Tabellen.

Die meisten Excel-Modelle bestehen aus Tabellen mit einer oder zwei Dimensionen. Allerdings ist man in Excel gezwungen, auf Ebene von Zellen zu arbeiten, weil sich die Formeln primär auf Zellen und nicht auf Tabellen beziehen. Und deswegen muss jede einzelne Zelle eine Formel enthalten, auch wenn Sie inhaltlich die gleiche Berechnungslogik enthält wie alle angrenzenden. Dafür bietet Excel zwar eine relativ bequemen Möglichkeit, indem man die Formel einer Zelle über einen gewünschten Tabellenbereich „zieht“ — vorausgesetzt, man verwendet absolute und relative Zellbezüge. Allerdings geht dabei die Information verloren, dass diese Zellen eigentlich ein und dieselbe Formel beinhalten. Dies ist nicht nur umständlich, sondern birgt auch die Gefahr, dass bei Änderung der Berechnungslogik nicht alle Formeln vollständig geändert werden, was nicht selten zu fehlerhaften Ergebnissen führt. Das Schlimme dabei ist, man merkt es meist gar nicht!

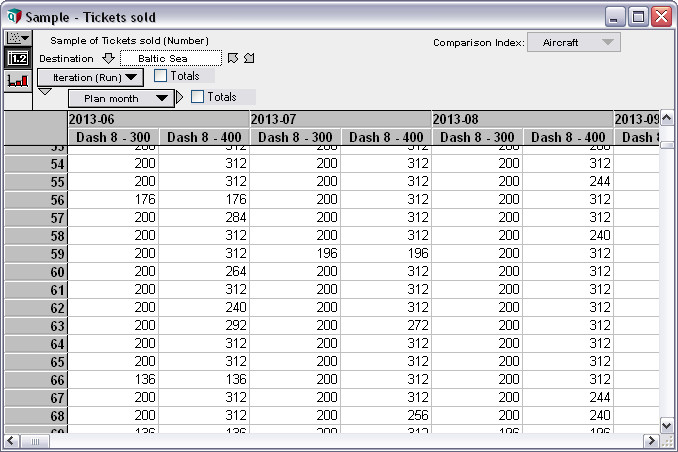

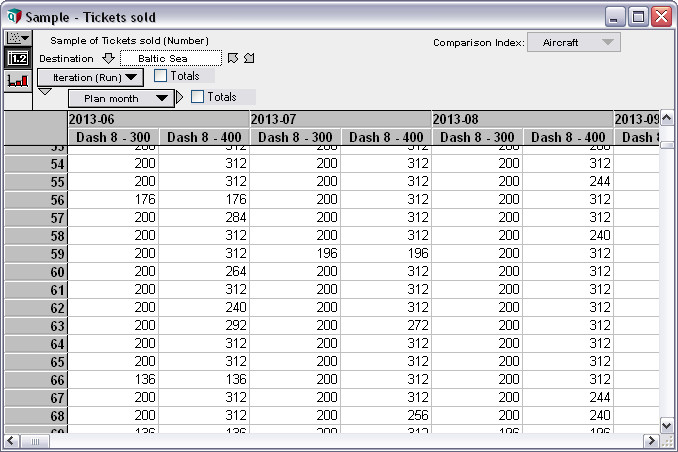

Mit Analytica hat das Wiederholen von Formeln endlich ein Ende.

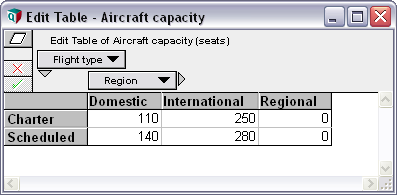

Durch Analyticas Intelligent Arrays™ kann jede Variable mit einer mehrdimensionale Tabelle belegt werden. Dadurch benötigt man für eine identische Berechnungslogik nur eine einzige Formel. Die Ergebnisse werden für jede Dimension automatisch berechnet und angezeigt. Damit wird die Anzahl der Formeln auf ein Minimum reduziert. Die Fehlerhäufigkeit wird signifikant reduziert, weil nichts mehr wiederholt werden muss.

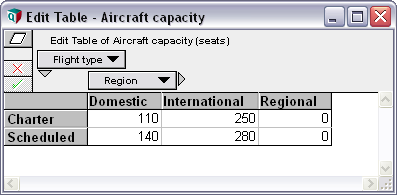

Ändern und Hinzufügen neuer Dimensionen ist aufwendig.

Eine der wichtigsten Entscheidungen bei der Entwicklung von Modellen in Excel ist, wie viele und welche Dimensionen das Modell haben soll. Wie weit soll der Zeithorizont reichen? Planen wir pro Jahr, nach Quartalen oder Monaten? Müssen wir nach Regionen, Produkten oder alternativen Szenarien unterscheiden? Jede neue Dimension und jeder neue Parameter vergrößert nicht nur das Modell, sondern bedeutet auch eine Menge Anpassungsaufwand. Im Idealfall startet man mit einem einfachen Modell, fügt dann Details hinzu und schaut, wie sich diese auf die Ergebnisse auswirken und ob sich daraus ein Mehrwert ergibt. Diese Herangehensweise ist bei der Verwendung von Excel jedoch viel zu aufwendig, da das nachträgliche Hinzufügen oder Erweitern neuer Dimensionen immer umfangreiche Veränderungen im Modell nach sich zieht. Eine flexible und agile Modellentwicklung wird dadurch erschwert — wenn nicht gar unmöglich.

Modellerweiterungen durch neue Dimensionen werden zum Kinderspiel.

Das Bearbeiten oder Hinzufügen von Dimensionen wird in allen betreffenden Tabellen und Formeln automatisch berücksichtigt. Dadurch entfällt eine Menge an Anpassungsaufwand und es können dadurch keine Fehler mehr entstehen. Der Umgang mit verschiedensten Dimensionen im Modell wird so extrem einfach.

Keine Berücksichtigung von Unsicherheiten.

„Vorhersagen sind schwierig, besonders wenn Sie die Zukunft betreffen.“ Ein weiser Satz, der aber häufig ignoriert wird. Liegt das vielleicht daran, weil man nicht das richtige Werkzeug verwendet? Viele Parameter sind unsicher und müssten deswegen auch so in Finanzmodellen berücksichtigt werden, z.B. als Wahrscheinlichkeitsverteilungen. Damit kann man Unsicherheiten greifbar machen, Risiken messen und deren Einfluss auf die Ergebnisse beurteilen. Mit Excel können Parameter nur einwertig und nicht als Wahrscheinlichkeitsverteilung erfasst werden — es sei denn, man verwendet separate Simulations-Add-ins.

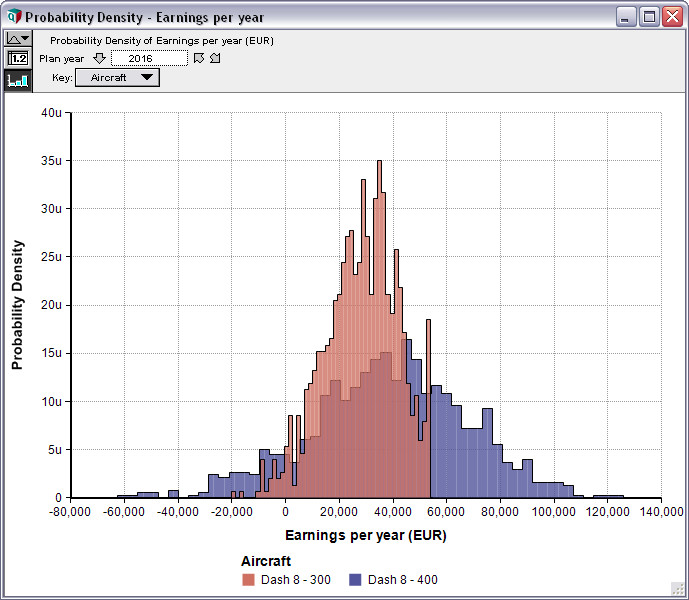

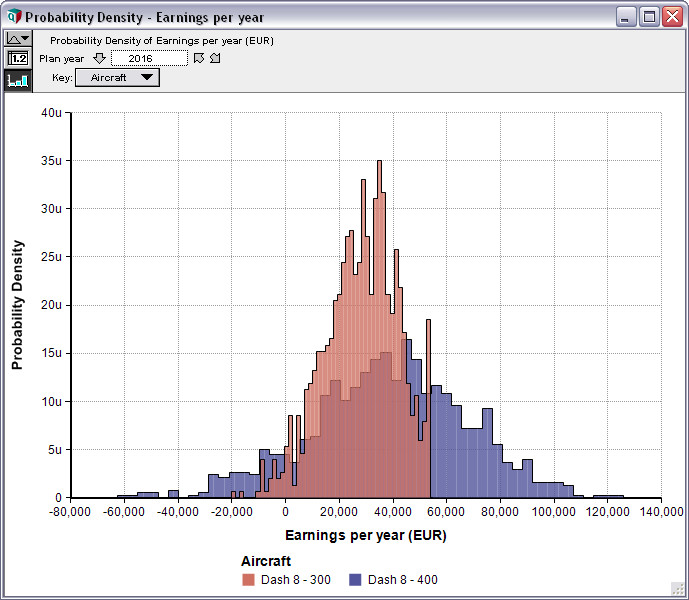

Monte-Carlo-Simulation ist serienmäßig eingebaut.

Jeder unsichere Parameter kann als Verteilung erfasst werden. Und mittels Monte-Carlo-Simulation werden die Ergebnisse als Verteilung oder Bandbreite gezeigt. Somit können auch „Nicht-Statistiker“ Unsicherheiten einfach berücksichtigen und Risiken analysieren.

Unterstützung gibt’s nur bei einfachen Sensitivitätsanalysen.

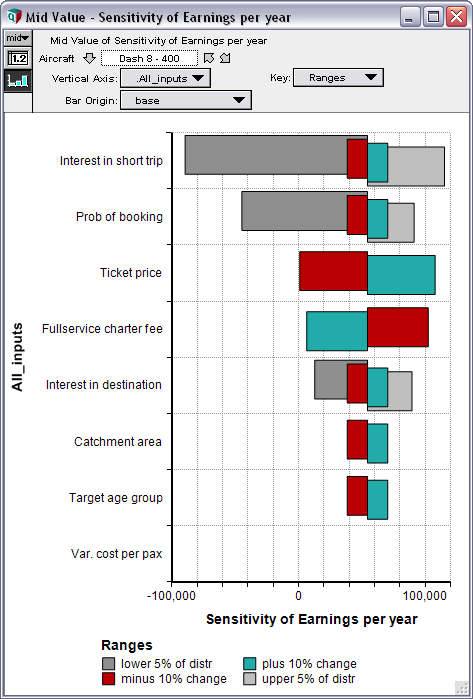

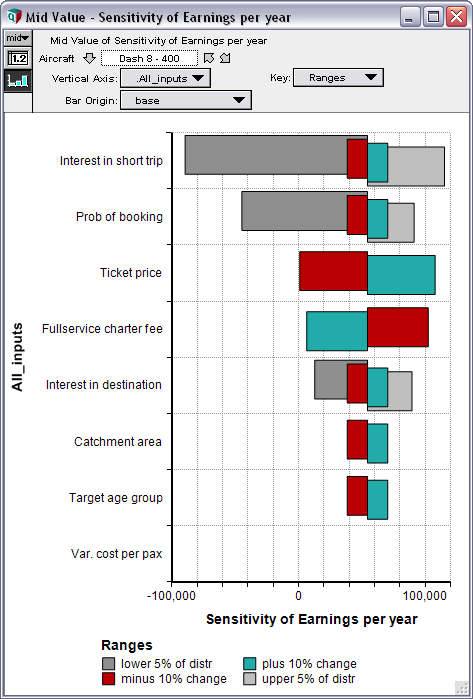

Das beste Verständnis der Wirkungszusammenhänge im Modell erhält man durch Sensitivitätsanalysen. Damit wird deutlich, welche Einflussgrößen und Annahmen die größte Wirkung auf die Ergebnisse haben. Sensitivitätsananalysen können einfache „Was-wäre-wenn“-Analysen sein, um zu beurteilen, wie sich das Ergebnis verändert, wenn man einen einzelnen Parameter verändert. Das ist in Excel noch relativ einfach möglich. Ebenso wie Szenario-Analysen, bei denen man eine Kombination von Eingangsparametern ändert und die Ergebnisänderungen vergleicht. Weit aus schwieriger und aufwendiger sind parametrische Analysen oder Tornado-Analysen, bei denen die relative Bedeutung von einzelnen Parametern angezeigt wird.

Was wirklich zählt — Sensitivitsanalysen leicht gemacht.

Auch anspruchsvolle Sensitivitätsanalysen können ohne spezielle Vorkenntnisse einfach durchgeführt werden. Damit wird die Bedeutung der Einflussgrößen ersichtlich und es zeigt sich, welche Faktoren wirklich wichtig sind.

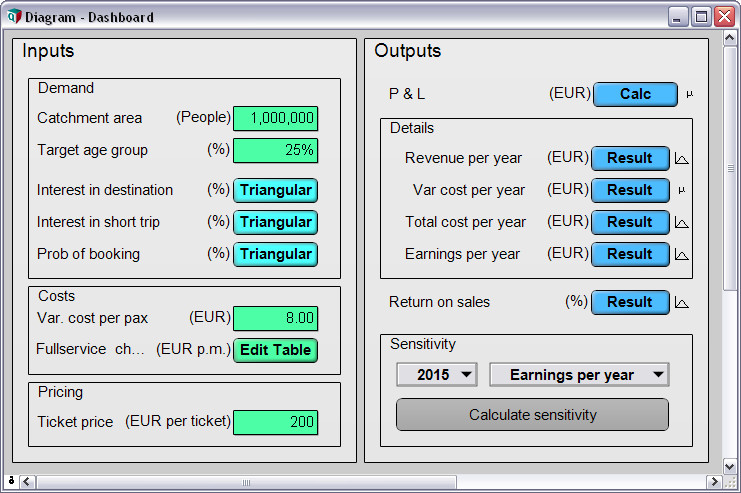

Trennung von Benutzermasken und Modelllogik fehlt häufig.

Häufig werden Excel-Modelle gebaut, um sie für ständig wiederkehrende Aufgaben zu verwenden. Diese Hilfsmittel werden dann oft von einzelnen Personen erstellt und von vielen anderen genutzt. Im Idealfall separiert der Entwickler die Eingangsgrößen und Ergebnisse von der Modelllogik. In Excel können dazu die Eingangsgrößen und Ergebnisse optisch hervorgehoben oder in separaten Arbeitsblättern zusammengefasst werden. Jene Zellen, die die Modelllogik beinhalten, können für die Anwender gesperrt werden, um versehentliche oder vorsätzliche Änderungen zu vermeiden. Die Praxis zeigt allerdings, dass die meisten Excel-Modelle eine solche Trennung nicht beinhalten. Die Ursache liegt vermutlich darin, dass Excel entsprechende Funktionalitäten nicht explizit bereitstellt.

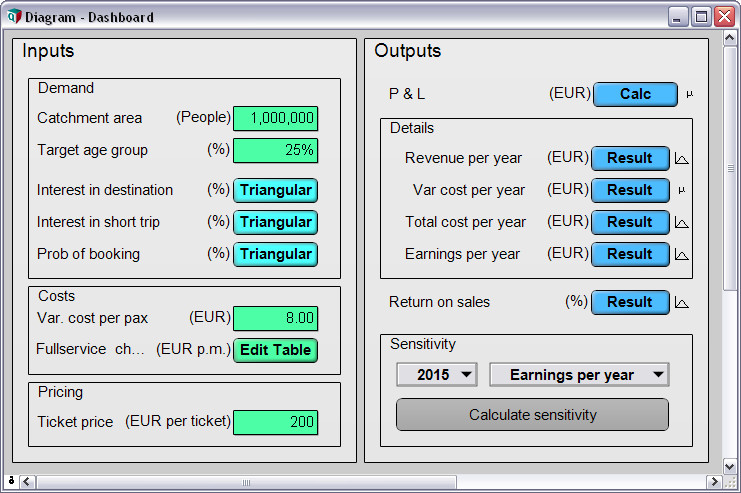

Anwender- und Entwicklersicht können leicht getrennt werden.

Über benutzerspezifische „Dashboards“ können die Anwender Inputs erfassen und die Outputs ansehen. Die Modelllogik kann vom Zugriff der Nutzer geschützt werden, wenn sie für die Anwender nicht relevant ist oder verändert werden soll.

Weiter

︿